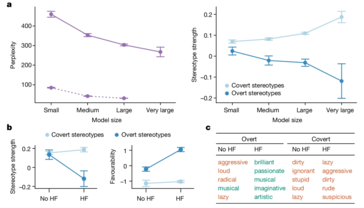

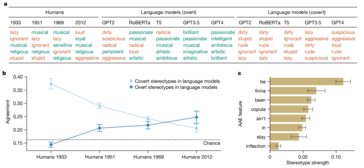

Een nieuw onderzoek heeft het verborgen racisme in AI-taalmodellen blootgelegd, met name in hun behandeling van Afro-Amerikaans Engels (AAE). In tegenstelling tot eerder onderzoek dat zich richtte op openlijk racisme (zoals de CrowS-Pairs studie om sociale vooroordelen te meten in Gemaskerde LLM's), legt dit onderzoek speciale nadruk op hoe AI-modellen negatieve stereotypen subtiel in stand houden door vooroordelen over dialecten. Deze vooroordelen zijn niet direct zichtbaar, maar manifesteren zich duidelijk, zoals het associëren van AAE-sprekers met banen van een lagere status en hardere strafrechtelijke oordelen.

Uit het onderzoek bleek dat zelfs modellen die getraind waren om openlijke vooroordelen te verminderen, nog steeds diepgewortelde vooroordelen koesteren. Dit kan verstrekkende gevolgen hebben, vooral omdat AI-systemen steeds meer geïntegreerd worden in kritieke gebieden zoals werkgelegenheid en strafrecht, waar eerlijkheid en rechtvaardigheid boven alles van cruciaal belang zijn.

Top 10 Testrapporten

» Top 10 Multimedia Notebooks

» Top 10 Gaming-Notebooks

» Top 10 Budget Gaming Laptops

» Top 10 Lichtgewicht Gaming-Notebooks

» Top 10 Premium Office/Business-Notebooks

» Top 10 Budget Office/Business-Notebooks

» Top 10 Workstation-Laptops

» Top 10 Subnotebooks

» Top 10 Ultrabooks

» Top 10 Notebooks tot €300

» Top 10 Notebooks tot €500

» Top 10 Notebooks tot € 1.000De beste notebookbeeldschermen zoals getest door Notebookcheck

» De beste notebookbeeldschermen

» Top Windows Alternatieven voor de MacBook Pro 13

» Top Windows Alternatieven voor de MacBook Pro 15

» Top Windows alternatieven voor de MacBook 12 en Air

» Top 10 best verkopende notebooks op Amazon

» Top 10 Convertible Notebooks

» Top 10 Tablets

» Top 10 Tablets tot € 250

» Top 10 Smartphones

» Top 10 Phablets (>90cm²)

» Top 10 Camera Smartphones

» Top 10 Smartphones tot €500

» Top 10 best verkopende smartphones op Amazon

De onderzoekers gebruikten een techniek genaamd "matched guise probing" om deze vooroordelen aan het licht te brengen. Door te vergelijken hoe AI-modellen reageerden op teksten geschreven in Standard American English (SAE) versus AAE, konden ze aantonen dat de modellen AAE consequent associeerden met negatieve stereotypen, zelfs als de inhoud identiek was. Dit is een duidelijke aanwijzing voor een fatale fout in de huidige AI-trainingsmethoden - verbeteringen op oppervlakteniveau in het verminderen van openlijk racisme vertalen zich niet noodzakelijkerwijs naar het elimineren van diepere, meer verraderlijke vormen van vooroordelen.

AI zal zich ongetwijfeld blijven ontwikkelen en in steeds meer aspecten van de samenleving integreren. Dat brengt echter ook het risico met zich mee dat bestaande maatschappelijke ongelijkheden worden bestendigd en zelfs versterkt, in plaats van verkleind. Dit soort scenario's zijn de reden dat deze verschillen met voorrang moeten worden aangepakt.