Manus AI heeft zijn nieuwe algemene AI-agent gelanceerd die in staat is om zelfstandig antwoorden te zoeken op complexe prompts door meerdere AI grote taalmodellen (LLM's) parallel te gebruiken. De AI is momenteel beschikbaar via door een uitnodiging aan te vragen.

Gangbare chatbots, zoals OpenAI ChatGPT, Microsoft CoPilot en Anthropic Claude, worden getraind op een vaste set gegevens, dus hun kennis is beperkt. Vragen zonder antwoorden in hun trainingsdataset kunnen niet worden beantwoord, hoewel sommige bedrijven proberen chatbots uit te breiden door ze toegang te geven tot het internet voor de meest recente informatie. Toch kunnen deze chatbots geen complexe vragen beantwoorden die probleemoplossing vereisen.

Sommige AI-bedrijven hebben geprobeerd dit aan te pakken door de AI stap voor stap problemen te laten doordenken, de gegevens die het online vindt te analyseren en een antwoord te laten samenstellen. OpenAI Deep Research is zo'n AI-agent die vorige maand werd uitgebracht, en Manus AI is de nieuwste.

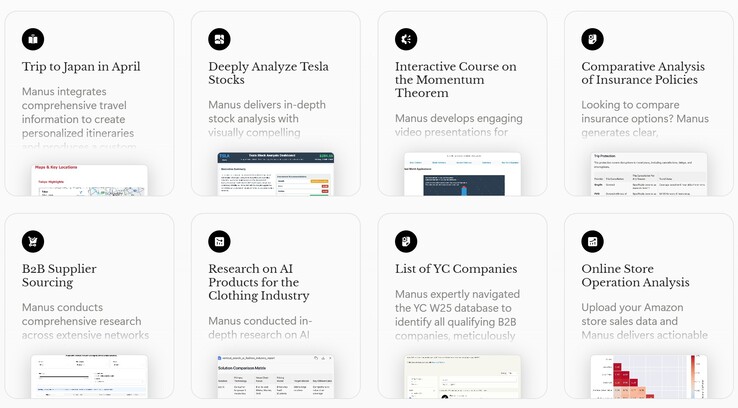

In tegenstelling tot OpenAI gebruikt de agent van Manus meerdere AI LLM's, waardoor hij profiteert van de voordelen die elk van hen biedt. Prompts worden automatisch opgesplitst in kleinere taken waar parallel aan gewerkt wordt. Gebruikers kunnen de gedachtegang van de AI volgen terwijl deze automatisch stap voor stap aan problemen begint te werken. De agent kan niet alleen tekstantwoorden produceren, maar ook spreadsheets, interactieve grafieken, webpagina's en videospelletjes.

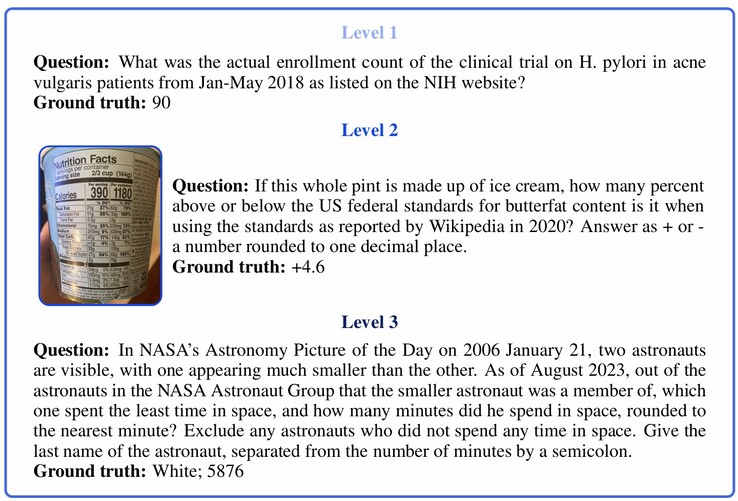

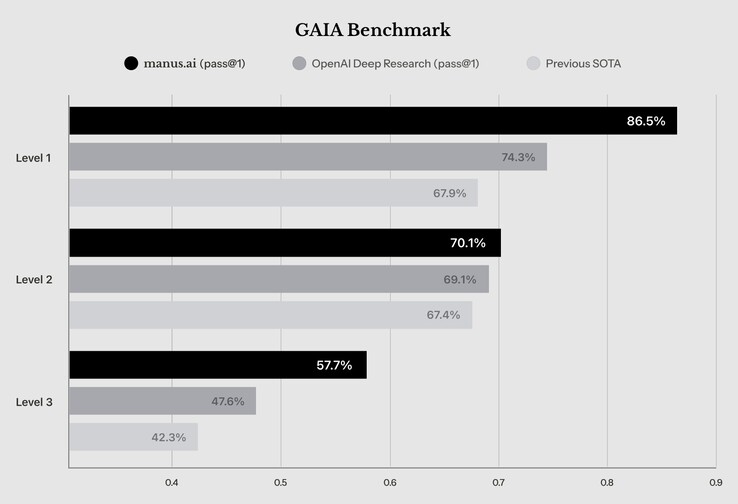

Hoewel de agent van Manus AI slechts 57,7% scoort op vragen van niveau 3 in de GAIA AI-benchmark, een test van vragen uit de echte wereld die zelfs mensen moeilijk kunnen beantwoorden, is de AI-agent in staat om eenvoudigere vragen van niveau 1 en 2 in meer dan 70% van de gevallen correct te beantwoorden. Volgens Manus AI presteert de agent beter dan andere AI die vandaag de dag in staat is om antwoorden op te zoeken.

Bron(nen)

Top 10 Testrapporten

» Top 10 Multimedia Notebooks

» Top 10 Gaming-Notebooks

» Top 10 Budget Gaming Laptops

» Top 10 Lichtgewicht Gaming-Notebooks

» Top 10 Premium Office/Business-Notebooks

» Top 10 Budget Office/Business-Notebooks

» Top 10 Workstation-Laptops

» Top 10 Subnotebooks

» Top 10 Ultrabooks

» Top 10 Notebooks tot €300

» Top 10 Notebooks tot €500

» Top 10 Notebooks tot € 1.000De beste notebookbeeldschermen zoals getest door Notebookcheck

» De beste notebookbeeldschermen

» Top Windows Alternatieven voor de MacBook Pro 13

» Top Windows Alternatieven voor de MacBook Pro 15

» Top Windows alternatieven voor de MacBook 12 en Air

» Top 10 best verkopende notebooks op Amazon

» Top 10 Convertible Notebooks

» Top 10 Tablets

» Top 10 Tablets tot € 250

» Top 10 Smartphones

» Top 10 Phablets (>90cm²)

» Top 10 Camera Smartphones

» Top 10 Smartphones tot €500

» Top 10 best verkopende smartphones op Amazon