Vorige week introduceerden onderzoekers op Apple OpenELM, een serie "open-source efficiënte taalmodellen", op de Hugging Face modelbibliotheek. De vier varianten variëren in grootte van 270 miljoen parameters tot 3 miljard, en zijn de meest waarschijnlijke kandidaten voor on-device AI voor Apple apparaten.

Voor de context Apple stilletjes een raamwerk voor machinaal leren genaamd MLX in december 2023. De volgende was MLLM-geleide beeldbewerking (MGIE)gevolgd door een opeenvolging van generatieve AI-inspanningen, waaronder Keyframer, Ferret-UI en AI-code-aanvulling in Xcode. Voor het grootste deel maken deze projecten gebruik van de verwerkingskracht van Apple silicium in plaats van de AI-functionaliteit over te hevelen naar de cloud.

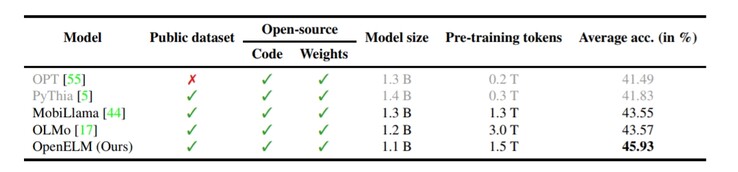

In dezelfde geest vertegenwoordigt OpenELM Apple's on-device benadering van AI. Over het algemeen gebruiken openbare LLM's honderden miljarden (soms triljoenen) variabelen om invoer van de gebruiker te begrijpen en een passend antwoord te bepalen. Aan de andere kant gebruiken kleinere taalmodellen zoals Microsofts Phi-3 slechts 3,8 miljard parameters, terwijl Google Gemma kan bogen op 2 miljard. Dankzij OpenELM's unieke benadering van de architectuur van het transformatormodel, komt het model echter uit op slechts 270 miljoen parameters.

Er zijn uiteraard enkele nadelen aan klein zijn. OpenELM is bijvoorbeeld niet multimodaal, omdat het te weinig parameters heeft om dat haalbaar te maken. Daarnaast is de feitenkennis vrij laag, zoals is aangetoond via het technisch rapport. Dit probleem speelt bij alle openbare LLM's van vergelijkbare grootte. Door de kleine omvang kan het AI-model echter lokaal op telefoons of laptops worden gehost in plaats van via de cloud.

Top 10 Testrapporten

» Top 10 Multimedia Notebooks

» Top 10 Gaming-Notebooks

» Top 10 Budget Gaming Laptops

» Top 10 Lichtgewicht Gaming-Notebooks

» Top 10 Premium Office/Business-Notebooks

» Top 10 Budget Office/Business-Notebooks

» Top 10 Workstation-Laptops

» Top 10 Subnotebooks

» Top 10 Ultrabooks

» Top 10 Notebooks tot €300

» Top 10 Notebooks tot €500

» Top 10 Notebooks tot € 1.000De beste notebookbeeldschermen zoals getest door Notebookcheck

» De beste notebookbeeldschermen

» Top Windows Alternatieven voor de MacBook Pro 13

» Top Windows Alternatieven voor de MacBook Pro 15

» Top Windows alternatieven voor de MacBook 12 en Air

» Top 10 best verkopende notebooks op Amazon

» Top 10 Convertible Notebooks

» Top 10 Tablets

» Top 10 Tablets tot € 250

» Top 10 Smartphones

» Top 10 Phablets (>90cm²)

» Top 10 Camera Smartphones

» Top 10 Smartphones tot €500

» Top 10 best verkopende smartphones op Amazon

Applede openbare release van OpenELM wijkt af van de gebruikelijke praktijken van het bedrijf. Van het complete raamwerk en de evaluatie van het model, tot de trainingslogboeken, pretrainingconfiguraties en de MLX-inferentiecode, elk aspect van het taalmodel is openbaar beschikbaar via Hugging Face voor ontwikkelaars om aan te passen en opnieuw te gebruiken voor verschillende gebruikssituaties. Ogenschijnlijk zou zo'n uitgebreide release Apple's belang in AI moeten versterken door onderzoekers te inspireren om te spelen met de mogelijkheden op Apple apparaten.

Maar er zijn andere spelers in deze ruimte. De Phi-3 van Microsoft is een zeer competente concurrent, net als de andere open LLM-projecten uit Redmond. Google's 2B - 3B Gemma is een andere. Hoewel alle bovengenoemde modellen nog steeds te langzaam draaien, gaan de hardware en software zeker in de goede richting voor kleine taalmodellen.

Voorlopig kunnen edge-apparaten zoals de Samsung Galaxy S24 (vanaf $799 op Amazon), of de OnePlus 12R die gebruik maakt van de interne Andes-GPT model gebruikt, moeten vertrouwen op cloudverwerking. Of Apple OpenELM nu wel of niet opneemt in de volgende iPhone, het is waarschijnlijk dat het bedrijf uit Cupertino zal samenwerken met Google of Open AI voor zwaardere generatieve AI-functies.