Het is vooral de gegevensoverdracht die een groot deel van het energieverbruik veroorzaakt. Dit is nog meer het geval bij de enorme hoeveelheden gegevens waarmee algoritmen voor kunstmatige intelligentie werken.

Het weglaten van deze stap, die ook als een knelpunt tussen geheugen en logische processen wordt beschouwd, heeft daarom een enorme impact. En dit is precies waar een idee uit 2003 om de hoek komt kijken, dat destijds werd ontwikkeld aan de Universiteit van Minnesota.

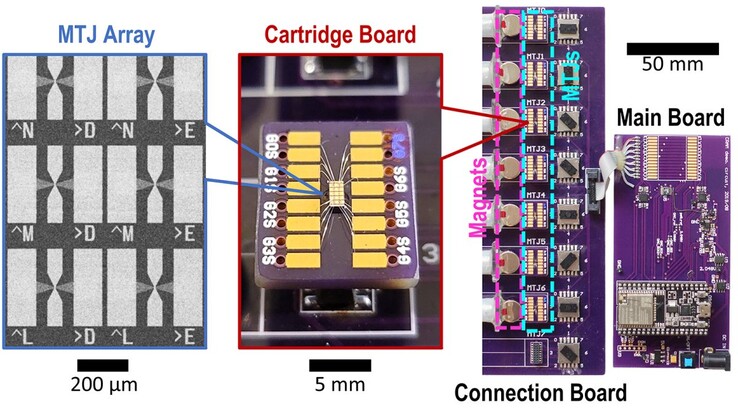

Dit leidde tot een samenwerking tussen verschillende disciplines, van natuurkunde tot techniek en informatica. Het resultaat was een aantal schakelingen die vandaag de dag gebruikt worden in slimme horloges en geheugenelementen.

Computational Random Access Memory, of CRAM, was er ook bij betrokken. Hiermee kan de feitelijke berekening en uitvoering van parallelle processen direct in het hoofdgeheugen en daarin op elke willekeurige locatie plaatsvinden.

Meer dan alleen een nieuwe architectuur

Bovendien zijn dit geen conventionele circuits, maar magnetische tunnelcontacten die de spin van het elektron in plaats van de lading kunnen gebruiken om tussen 0 en 1 te schakelen.

In toepassingen gebaseerd op kunstmatige intelligentie resulteert dit in een stroomverbruik van een duizendste om uiteindelijk hetzelfde resultaat te bereiken als met de klassieke methode. Het huidige en voorspelde elektriciteitsverbruik van neurale netwerken wereldwijd laat zien hoe enorm deze hoeveelheid elektriciteit is. Volgens het Internationaal Energie Agentschap werd er in 2022 460 terawattuur gebruikt. Uiterlijk in 2026 zal dit naar verwachting 1.000 terawattuur zijn.

Met het gigantische besparingspotentieel van 99,9 procent zou er dan 999 terawattuur overblijven die niet meer nodig zou zijn. Dit komt overeen met het jaarlijkse elektriciteitsverbruik van Japan, de op drie na grootste economie met 126 miljoen inwoners.

Volgens het artikel zou dit niet eens het best mogelijke resultaat zijn. Verdere tests zouden het energieverbruik met een factor 1.700 of 2.500 kunnen verminderen. Deze extra toename in efficiëntie wordt mogelijk gemaakt door een gerichte aanpassing van de CRAM aan individuele algoritmen, die nog sneller en dus economischer berekend kunnen worden.

Top 10 Testrapporten

» Top 10 Multimedia Notebooks

» Top 10 Gaming-Notebooks

» Top 10 Budget Gaming Laptops

» Top 10 Lichtgewicht Gaming-Notebooks

» Top 10 Premium Office/Business-Notebooks

» Top 10 Budget Office/Business-Notebooks

» Top 10 Workstation-Laptops

» Top 10 Subnotebooks

» Top 10 Ultrabooks

» Top 10 Notebooks tot €300

» Top 10 Notebooks tot €500

» Top 10 Notebooks tot € 1.000De beste notebookbeeldschermen zoals getest door Notebookcheck

» De beste notebookbeeldschermen

» Top Windows Alternatieven voor de MacBook Pro 13

» Top Windows Alternatieven voor de MacBook Pro 15

» Top Windows alternatieven voor de MacBook 12 en Air

» Top 10 best verkopende notebooks op Amazon

» Top 10 Convertible Notebooks

» Top 10 Tablets

» Top 10 Tablets tot € 250

» Top 10 Smartphones

» Top 10 Phablets (>90cm²)

» Top 10 Camera Smartphones

» Top 10 Smartphones tot €500

» Top 10 best verkopende smartphones op Amazon